为促进搜索内容生态健康发展,保障用户的浏览体验,搜狗搜索将于6月17日推出石破算法。该算法旨在对包含恶劣采集行为的链接、网站进行识别,根据网站作弊程度落实相应的清洗打压措施。恶劣采集标准解读与示例如下,烦请合作方自查并于算法上线前完成全面整改。

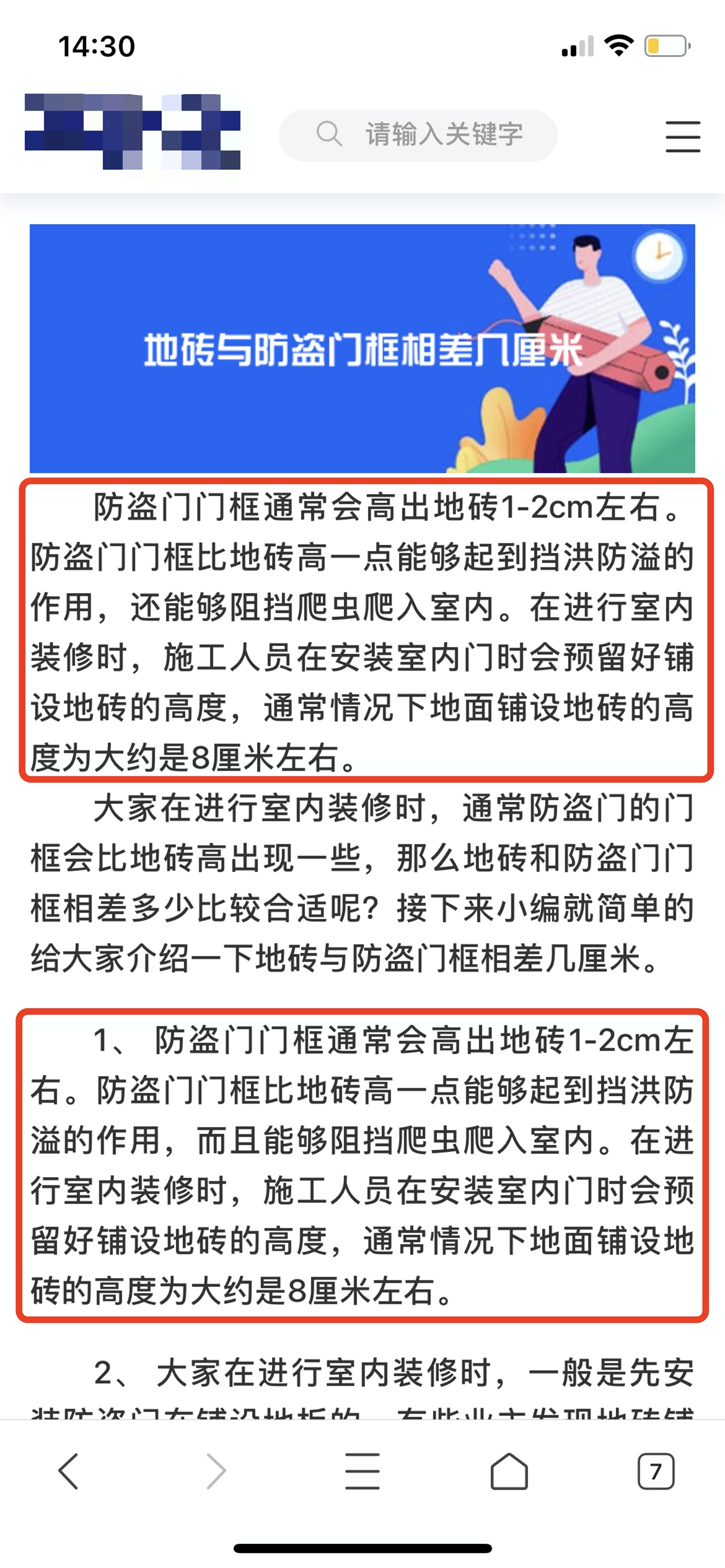

1. 内容逻辑混乱:采集不同文章进行拼凑或相同文章的重复片段堆叠成一篇文章,文章前后无逻辑关系,致使用户理解困难;

图1.1 正文内无相关关系

图1.2 内容重复堆叠

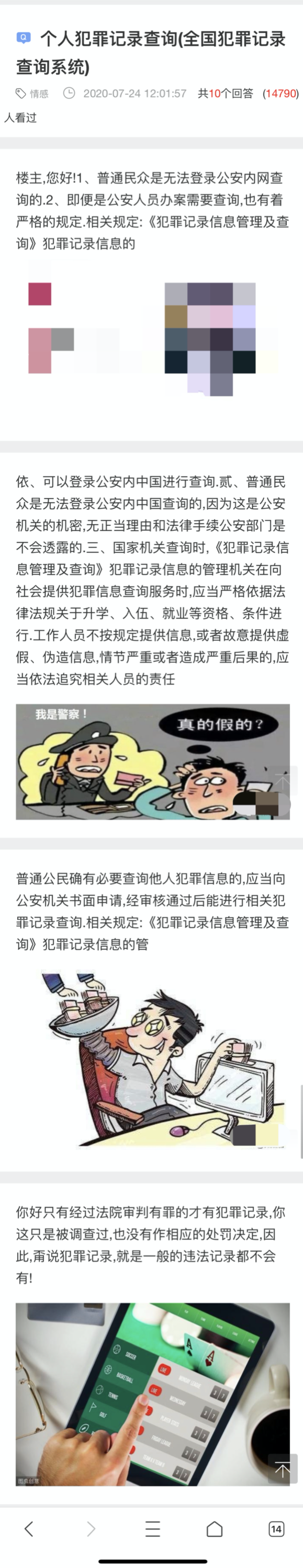

2. 内容结构混乱:采集后未进行编辑导致的文章排版混乱、无关信息冗杂、功能丢失等问题,难以为用户提供有效信息;

图2.1 缺少问答结构

3. 网站由大量采集内容构成:网站缺少原创/独有内容,即多为批量采集并未进行编辑整理的内容,整体内容质量较低 ;

图3.1 相同采集内容反复应用

图3.2 批量生成文章配图

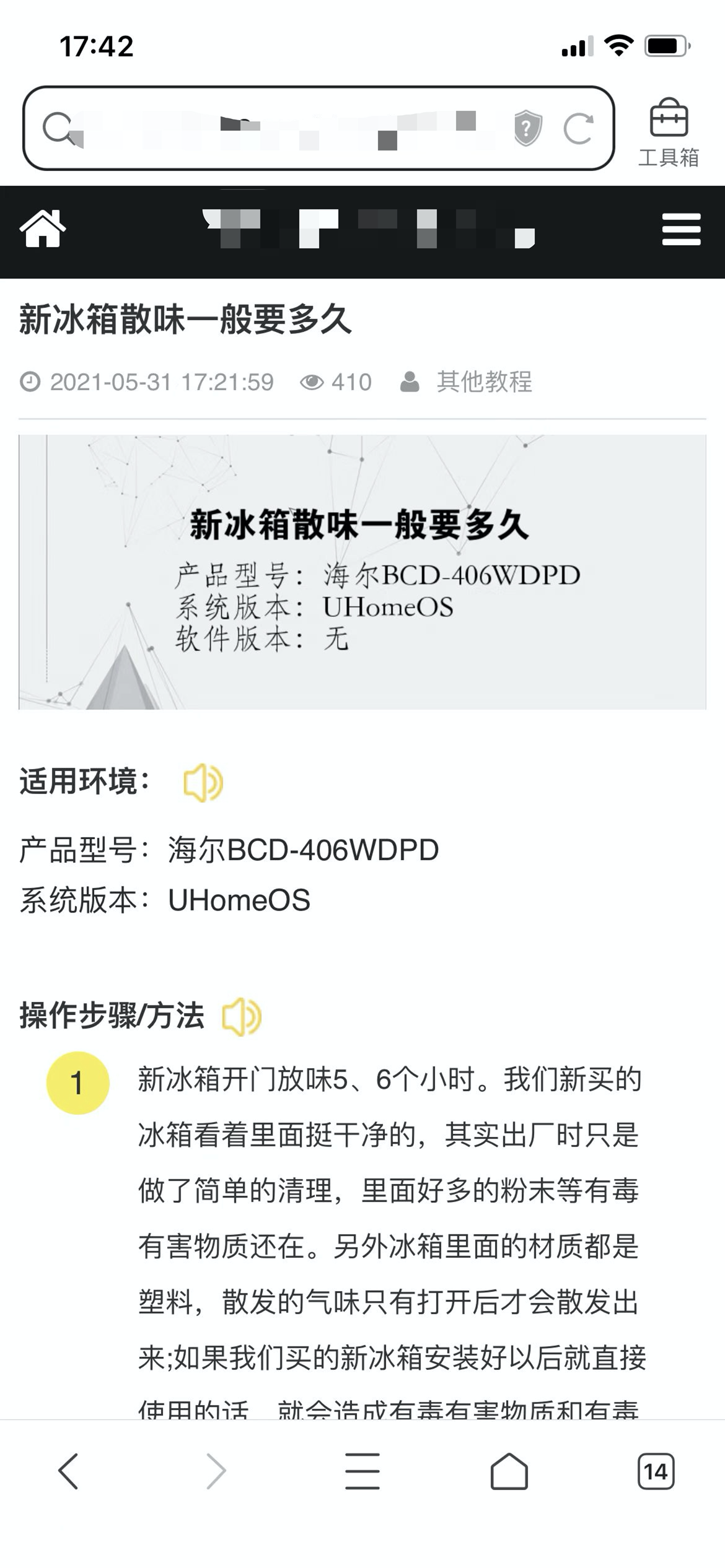

4. 跨领域采集:网站采集大量与主要经营领域无关内容用以获取流量的行为也会被判定为恶劣采集;

图4.1 主营设计领域网站采集大量无关内容

TAG标签:

0条评论

官方微信号

官方微信号 解答老师微信

解答老师微信 湘公网安备 43010402000980号

湘公网安备 43010402000980号